ИИ все чаще используется для определения эмоций. Вот что поставлено на карту

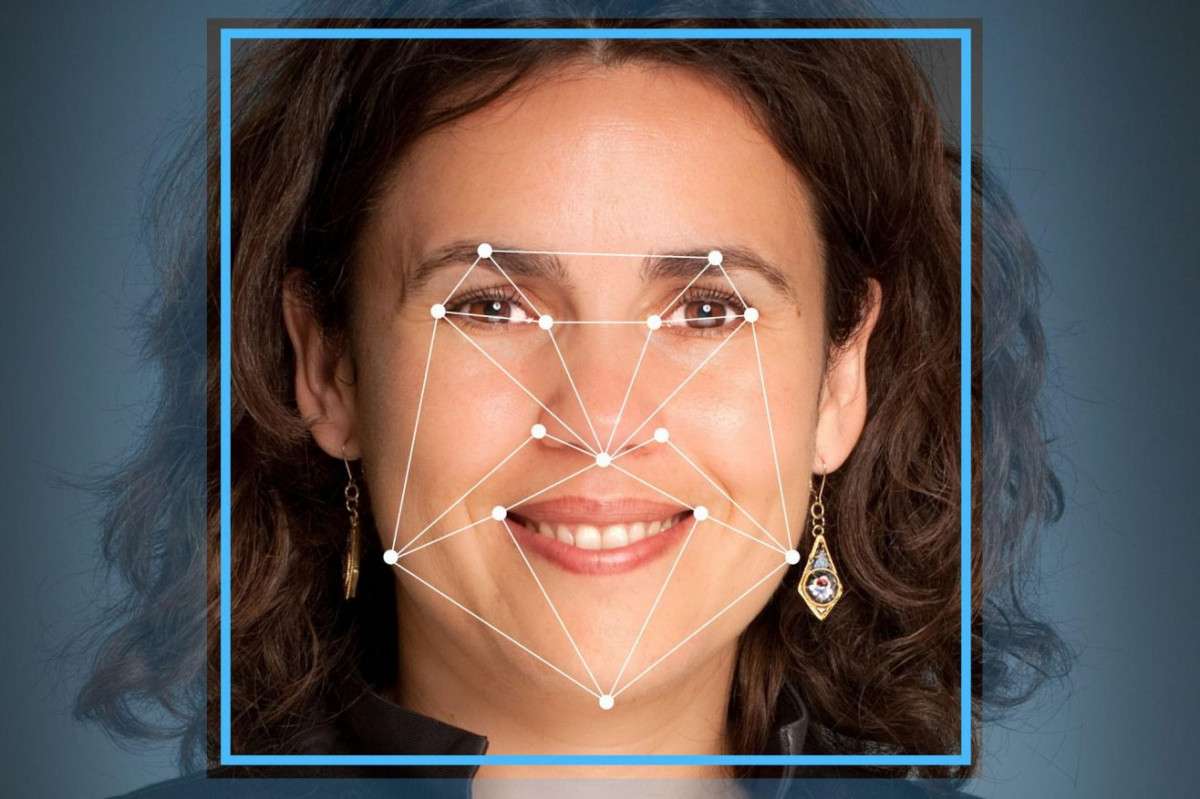

Представьте, что вы проходите собеседование. Когда вы отвечаете на вопросы рекрутера, система искусственного интеллекта (ИИ) сканирует ваше лицо, оценивая нервозность, сочувствие и надежность. Это может звучать как научная фантастика, но эти системы все чаще используются, часто без ведома и согласия людей.

Технология распознавания эмоций (ERT) на самом деле является быстрорастущей многомиллиардной отраслью, целью которой является использование ИИ для обнаружения эмоций по мимике. Тем не менее, наука, лежащая в основе систем распознавания эмоций, противоречива: в системы встроены предубеждения.

Фото: https://tech.courses/

Фото: https://tech.courses/

Многие компании используют ERT для проверки реакции потребителей на их продукты, от хлопьев до видеоигр. Но его также можно использовать в ситуациях с гораздо более высокими ставками, например, при приеме на работу, службой безопасности аэропорта, чтобы отмечать лица как разоблачающие обман или страх, при пограничном контроле, в полицейской службе для выявления «опасных людей» или в образовании для отслеживания активности студентов с их домашним заданием.

Шаткая научная основа

К счастью, технология распознавания лиц привлекает внимание общественности. Отмеченный наградами фильм Coded Bias, недавно выпущенный на Netflix, документирует открытие, что многие технологии распознавания лиц не позволяют точно определять лица с более темной кожей. А исследовательская группа, управляющая ImageNet, одним из крупнейших и наиболее важных наборов данных, используемых для обучения распознаванию лиц, недавно была вынуждена размыть 1,5 миллиона изображений из соображений конфиденциальности.

Разоблачения алгоритмической предвзятости и дискриминационных наборов данных в технологии распознавания лиц привели к тому, что крупные технологические компании, включая Microsoft, Amazon и IBM, прекратили продажи. И эта технология сталкивается с юридическими проблемами в связи с ее использованием в полиции Великобритании. В ЕС коалиция из более чем 40 организаций гражданского общества призвала полностью запретить технологию распознавания лиц.

Как и другие формы распознавания лиц, ERT поднимает вопросы о предвзятости, конфиденциальности и массовом наблюдении. Но ERT вызывает другое беспокойство: наука об эмоциях, стоящая за ней, противоречива. Большинство ERT основано на теории «базовых эмоций», согласно которой эмоции являются биологически запрограммированными и выражаются одинаково людьми повсюду.

Однако это вызывает все большие сомнения. Исследования в области антропологии показывают, что эмоции по-разному выражаются в разных культурах и обществах. В 2019 году Ассоциация психологических наук провела обзор доказательств и пришла к выводу об отсутствии научной поддержки общепринятого предположения о том, что эмоциональное состояние человека можно легко определить по движениям его лица. Короче говоря, ERT построена на шаткой научной основе.

Фото: https://hightech.fm/

Фото: https://hightech.fm/

Кроме того, как и другие формы технологии распознавания лиц, ERT кодируется с расовым уклоном. Исследование показало, что системы постоянно воспринимают лица черных людей как более злые, чем лица белых, независимо от выражения лица. Хотя изучение расовых предубеждений в ERT мало, расовые предубеждения в других формах распознавания лиц хорошо задокументированы.

По словам исследователя искусственного интеллекта Деборы Раджи в интервью MIT Technology Review, эта технология может причинить вред людям двумя способами: «Один из способов – не работать: в силу того, что у цветных людей выше процент ошибок, это подвергает их большему риску. Вторая ситуация – когда это действительно работает – когда у вас есть идеальная система распознавания лиц, но ее легко использовать против сообществ, чтобы преследовать их».

Таким образом, даже если технология распознавания лиц может быть беспристрастной и точной для всех людей, она все равно может быть несправедливой. Мы видим эти несопоставимые эффекты, когда технология распознавания лиц используется в полицейских и судебных системах, которые уже являются дискриминационными и вредными для цветных. Технологии могут быть опасными, если они не работают должным образом. И они также могут быть опасны, когда отлично работают в несовершенном мире.

На проблемы, возникающие в связи с технологиями распознавания лиц, включая ERT, нет простых и ясных ответов. Решение проблем, представленных ERT, требует перехода от этики ИИ, основанной на абстрактных принципах, к этике ИИ, основанной на практике и влиянии на жизнь людей. Когда дело доходит до ERT, нам необходимо коллективно изучить противоречивую науку об эмоциях, встроенную в эти системы, и проанализировать их потенциал для расовых предубеждений. И мы должны спросить себя: даже если бы ERT можно было спроектировать так, чтобы точно читать внутренние чувства каждого, хотим ли мы такого интимного наблюдения в нашей жизни? Это вопросы, требующие обсуждения, вклада и действий каждого.

Комментарии